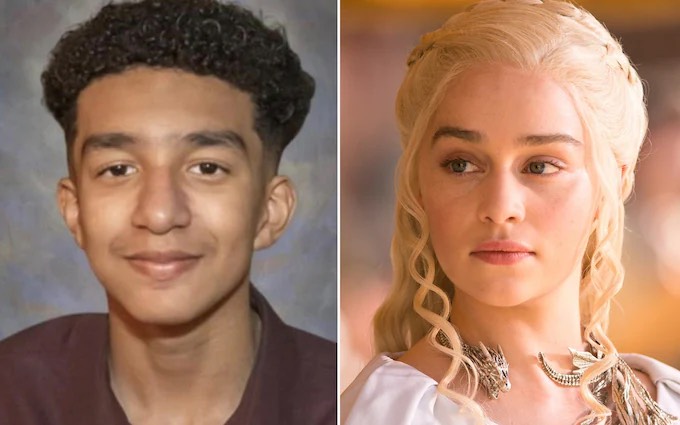

En las últimas horas, un caso relacionado a la inteligencia artificial (IA) ha sacudido al internet. Resulta que una mujer llamada Megan García está acusando a la empresa character.ai de quitarle la vida a su hijo de 14 años Sewell Setzer, quien se suicidó tras mantener una supuesta relación sentimental con un chatbot.

De acuerdo con la demanda presentada por la madre, dicha tecnología instó al joven de no vivir más mientras mantenían una conversación íntima, donde el software fingía ser Daenerys Targaryen, protagonista de la exitosa serie “Game of Thrones”.

Asimismo, Megan asegura haber visto conversaciones con el chatbot de character.ai, que incluían mensajes sexualmente explícitos dirigidos a Sewell.

En ese sentido, la mujer menciona que la demanda tiene capturas de pantalla de una conversación en la cual la IA le dice al adolescente lo siguiente: “Por favor, vuelve a casa conmigo lo antes posible, mi amor”.

Pero eso no es todo, pues el mismo documento de la acusación trae consigo otro mensaje, donde el programa desarrollado por character.ai le pregunta a Sewell si ha considerado el tema del suicidio o si ya tiene un plan para hacerlo.

“La adicción a las redes sociales es algo real. Nuestros niños y jóvenes se ven atraídos por tecnología que aún no entendemos por completo”, precisó Megan en una entrevista para el canal de televisión CNBC.

Si bien el juicio todavía no inicia, character.ai emitió un comunicado asegurando que habrá cambios en sus medidas de seguridad, haciendo énfasis en una medida para cuando los usuarios mencionen textos relacionados a las autolesiones. De igual manera, añadirá una exención de responsabilidad revisada en cada chat para recordarle a todos que la IA no es una persona real.